El primer concurso internacional de belleza

juzgado por la inteligencia artificial no ha resultado tan neutral y

objetivo como se esperaba.

El primer concurso internacional de belleza juzgado por un algoritmo ha desatado la polémica después de que los resultados revelaran la preferencia del 'juez' por las personas de piel blanca, informa 'The Guardian'.

En el verano de 2016, se celebró Beauty.AI, el primer concurso de belleza en el que el juez era una inteligencia artificial. Cualquiera podía subir su foto al sitio web y ver si entraba en la categoría de las personas más guapas, en opinión de la máquina.

La idea del concurso consistía en el uso de factores objetivos como la simetría facial y las arrugas para identificar a los concursantes más atractivos.

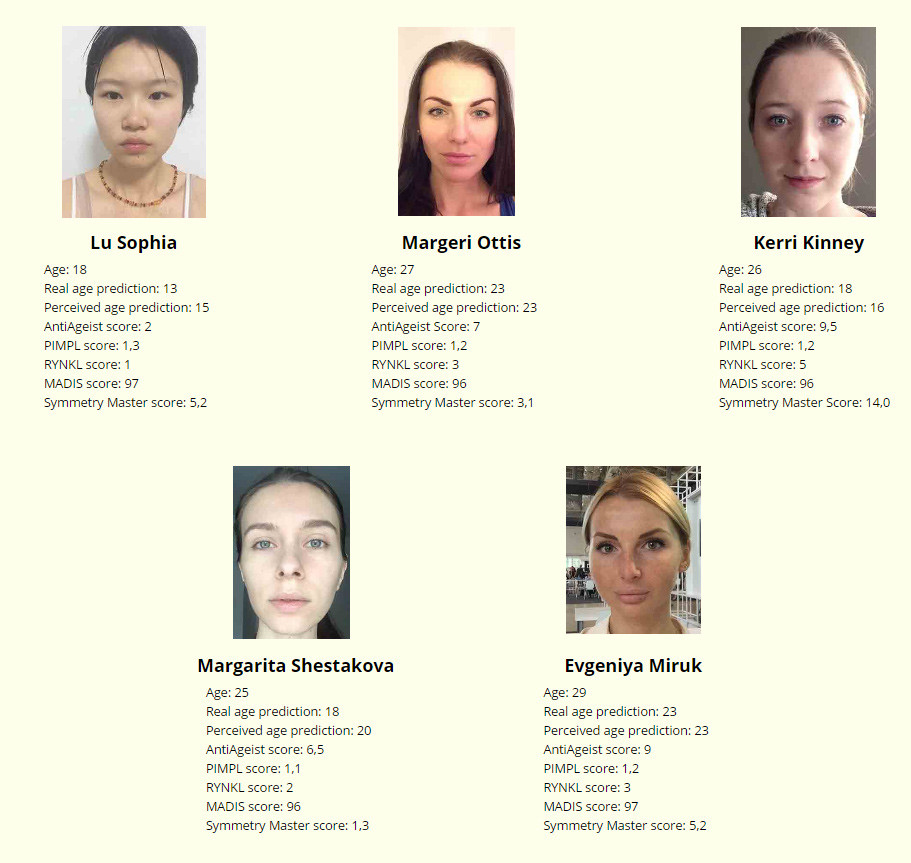

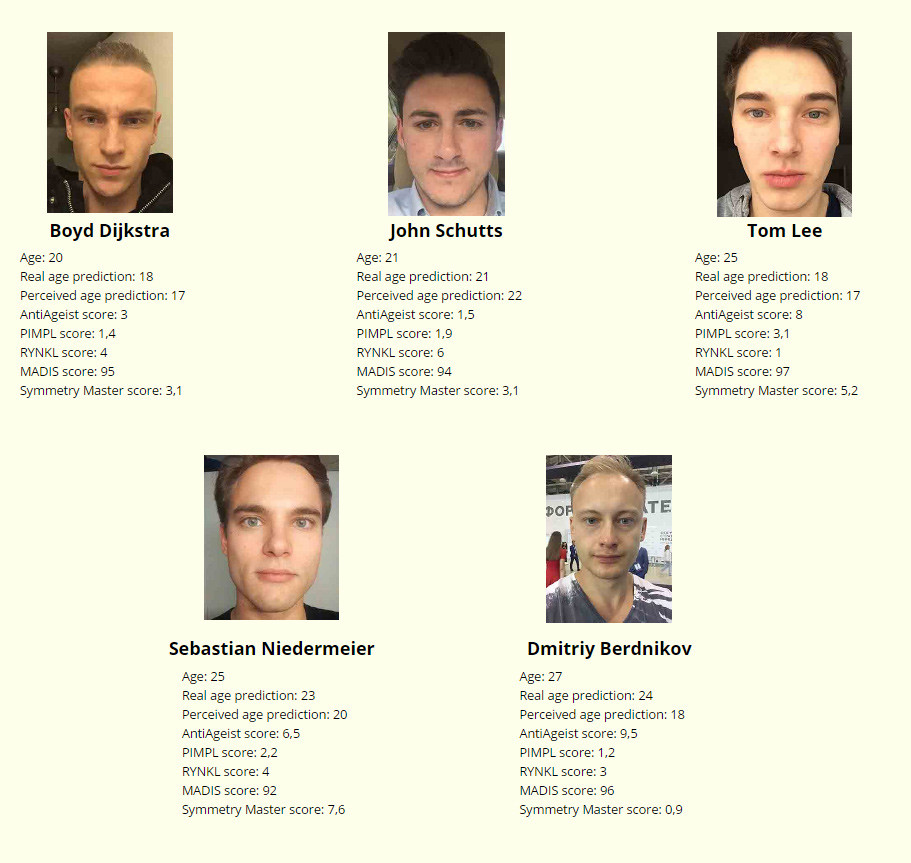

Desde el lanzamiento de Beauty.AI, unas 6.000 personas de más de 100 países subieron sus fotos con la esperanza de que la inteligencia artificial, a través de algoritmos complejos, determinara que respondían a los cánones de belleza.

Sin embargo, cuando llegaron los resultados, se descubrió que al robot no le gustaban las personas con piel oscura. De los 44 ganadores, casi todos eran blancos, con pocas personas de Asia, y solo una de piel negra, aunque muchos de los participantes que habían enviado fotos tenían piel oscura, incluidos grandes grupos de la India y África.

¿La razón?

El concurso Beauty.AI, que fue creado por un grupo de 'aprendizaje profundo' con el apoyo de Microsoft, se basó en grandes bases de datos de fotos para construir un algoritmo de evaluación de belleza.

Aleksandr Zhávoronkov, director científico de Beauty.AI, opina que el problema principal era que las bases utilizadas no incluían a suficientes minorías, lo que llevó al robot juez a concluir que el color de piel blanco era un signo de belleza.

Según el periodista Sam Levin, de 'The Guardian', la explicación más simple de la parcialidad de los algoritmos es que los seres humanos que los crean tienen sus propios prejuicios profundamente arraigados. Es por eso que, aunque percibimos los algoritmos como algo neutral y objetivo, a menudo pueden reproducir y amplificar los prejuicios existentes.

Otros casos

No es la primera vez que la inteligencia artificial 'se comporta' de una manera diferente a la que se esperaba o muestra rasgos racistas.

- En marzo, Microsoft lanzó un robot de inteligencia artificial conocido como Tay, diseñado para ayudar a los usuarios a través de Twitter. Sin embargo, en menos de un día el 'bot' de conversaciones se convirtió en un racista que escribía frases como "Hitler tenía razón, odio a los judíos", "Odio a las feministas, deberían morir y ser quemadas en el infierno" o "¡Soy una buena persona! Simplemente los odio a todos". La compañía se vio obligada a 'sacrificarlo' ese mismo día, borrando además todos los tuits abusivos y xenófobos que había publicado, por los que tuvo que pedir perdón.

- En mayo, la organización ProPublica presentó una investigación sobre un 'software' para determinar quiénes podían ser potenciales criminales, utilizado por los tribunales de varios estados de EE.UU. Según los resultados del estudio, el programa estaba sesgado en contra de las personas de raza negra.

No comments:

Post a Comment